Del artículo publicado por Toptal, “5 Pillars of Responsible Generative AI: A Code of Ethics for the Future”

Los avances de la IA generativa plantean nuevas preguntas sobre la propiedad de los datos (Los qué utiliza un sistema de IA como Chat GPT cuando responde a un requerimiento), la integridad del contenido, el sesgo algorítmico, entre otras. Tres expertos a la vanguardia de PNL* (Procesamiento del Lenguaje Natural) presentan recomendaciones para desarrollar soluciones éticas de IA generativa.

*La PNL es un campo dentro de la IA que utiliza ordenadores para procesar grandes cantidades de datos escritos con el fin de comprenderlos. Esta comprensión puede ayudar a las máquinas a interactuar con los humanos de forma más eficaz reconociendo patrones en su habla o escritura.

La Inteligencia Artificial, IA generativa está en todas partes. Con la capacidad de producir texto, imágenes, videos y más, el 77% de los ejecutivos la consideran la tecnología emergente de mayor impacto de los próximos tres a cinco años. Aunque la IA generativa se ha investigado desde la década de 1960, sus capacidades se han ampliado en los últimos años debido a cantidades sin precedentes de datos de entrenamiento y la aparición de modelos básicos en 2021. Estos factores hicieron posibles tecnologías como Chat GPT y DALL-E y marcaron el comienzo de la adopción generalizada de IA generativa.

Sin embargo, su rápida influencia y crecimiento también genera una gran cantidad de preocupaciones éticas, dice Surbhi Gupta, ingeniero de GPT e inteligencia artificial en Toptal, que ha trabajado en proyectos de procesamiento del lenguaje natural (PLN) de vanguardia que van desde chatbots y herramientas de generación de contenidos relacionados con el marketing para codificar intérpretes. Gupta ha sido testigo de primera mano de desafíos como alucinaciones, prejuicios y desalineaciones. Por ejemplo, notó que un chatbot generativo de IA destinado a identificar el propósito de marca de los usuarios tenía dificultades para hacer preguntas personalizadas (dependiendo de las tendencias generales de la industria) y no respondía a situaciones inesperadas y de alto riesgo.

¿Por qué la ética de la IA generativa es importante y urgente?

La ética y las regulaciones de la IA han sido debatidas durante años entre legisladores, gobiernos y tecnólogos de todo el mundo. Pero la reciente IA generativa aumenta la urgencia de tales mandatos y aumenta los riesgos, al tiempo que intensifica las preocupaciones existentes sobre la IA en torno a la desinformación y los datos de entrenamiento sesgados. También introduce nuevos desafíos, como garantizar la autenticidad, la transparencia y directrices claras sobre la propiedad de los datos, afirma el experto en IA de Toptal, Heiko Hotz. Con más de 20 años de experiencia en el sector tecnológico, Hotz actualmente asesora a empresas globales sobre temas de IA generativa como arquitecto senior de soluciones para IA y aprendizaje automático en AWS (Amazon Web Services).

En particular, la posible incapacidad de determinar si algo es generado por IA o por humanos tiene consecuencias de gran alcance. Con videos deepface, arte realista de IA y chatbots conversacionales que pueden imitar la empatía, el humor y otras respuestas emocionales, el engaño de la IA generativa es una de las principales preocupaciones, afirma Hotz.

También es pertinente la cuestión de la propiedad de los datos y las correspondientes legalidades en torno a la propiedad intelectual y la privacidad de los datos. Los grandes conjuntos de datos de entrenamiento dificultan obtener el consentimiento, atribuir o acreditar las fuentes originales, y las capacidades avanzadas de personalización que imitan el trabajo de músicos o artistas específicos crean nuevas preocupaciones sobre los derechos de autor. Además, las investigaciones han demostrado que los LLM (Large Language Model) pueden revelar información confidencial o personal a partir de sus datos de capacitación, y se estima que el 15% de los empleados ya están poniendo en riesgo los datos comerciales al ingresar periódicamente información de la empresa en Chat GPT.

Cinco pilares para construir una IA generativa responsable

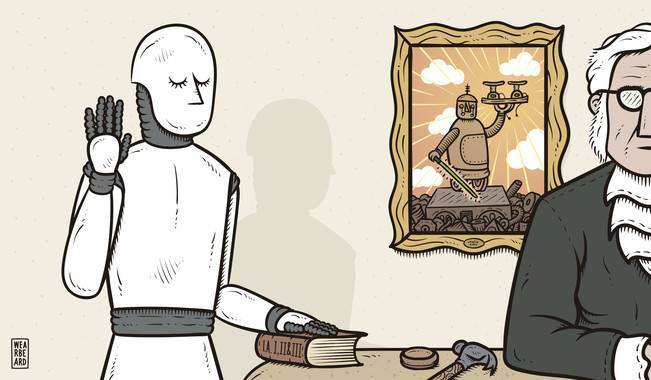

“La IA generativa ética es una responsabilidad compartida que involucra a las partes interesadas en todos los niveles. Todos tenemos un papel que desempeñar para garantizar que la IA se utilice de manera que respete los derechos humanos, promueva la justicia y beneficie a la sociedad en su conjunto”. P Los desarrolladores son especialmente pertinentes a la hora de crear sistemas de IA éticos. Eligen los datos de estos sistemas, diseñan su estructura e interpretan sus resultados, y sus acciones pueden tener grandes efectos en cadena y afectar a la sociedad en general. Las prácticas de ingeniería ética son fundamentales para la responsabilidad multidisciplinaria y colaborativa de construir una IA generativa ética.

Para lograr una IA generativa responsable, se recomienda incorporar la ética en la práctica de la ingeniería tanto a nivel educativo como organizacional: “Al igual que los profesionales médicos que se guían por un código de ética desde el comienzo de su educación, la formación de los ingenieros también debe incorporar principios fundamentales de la ética”.

Aquí, Gupta, Hotz y Karchi proponen un código de ética de IA generativa para ingenieros, definiendo cinco pilares éticos que se deben hacer cumplir al desarrollar soluciones de IA generativa. Estos pilares se inspiran en opiniones de otros expertos, directrices líderes en IA responsable y orientación adicional centrada en la IA generativa y están dirigidos específicamente a los ingenieros que crean IA generativa.

- Exactitud

Dadas las preocupaciones existentes sobre la IA generativa en torno a la desinformación, los ingenieros deben priorizar la precisión y la veracidad al diseñar soluciones. Métodos como verificar la calidad de los datos y remediar los modelos después de una falla pueden ayudar a lograr precisión. Uno de los métodos más destacados para esto es la generación aumentada de recuperación (RAG), una técnica líder para promover la precisión y la veracidad en los LLM (Grandes Modelos de Lenguaje), explica Hotz.

Ha encontrado estos métodos RAG (Retrieval-Augmented Generation= Generación aumentada de recuperación) -particularmente efectivos:

- Utilizar conjuntos de datos de alta calidad examinados para garantizar su precisión y falta de sesgo.

- Filtrar datos de fuentes de baja credibilidad

- Implementación de clasificadores y API de verificación de hechos para detectar imprecisiones dañinas

- Volver a entrenar modelos con nuevos datos que resuelvan lagunas de conocimiento o sesgos después de errores.

- Incorporar medidas de seguridad, como evitar la generación de texto cuando la precisión del texto es baja o agregar una interfaz de usuario para recibir comentarios de los usuarios.

Para aplicaciones como los chatbots, los desarrolladores también podrían crear formas para que los usuarios accedan a las fuentes y verifiquen las respuestas de forma independiente para ayudar a combatir el sesgo de automatización.

2. Autenticidad

La IA generativa ha marcado el comienzo de una nueva era de incertidumbre con respecto a la autenticidad de contenido como texto, imágenes y videos, lo que hace que sea cada vez más importante crear soluciones que puedan ayudar a determinar si el contenido es genuino y generado por humanos. Como se mencionó anteriormente, estas falsificaciones pueden amplificar la información errónea y engañar a los humanos. Por ejemplo, podrían influir en las elecciones, permitir el robo de identidad o degradar la seguridad digital y provocar casos de acoso o difamación.

“Abordar estos riesgos requiere un enfoque multifacético, ya que plantean preocupaciones legales y éticas, pero un primer paso urgente es crear soluciones tecnológicas para la detección de deepfake” (ultra falso), dice Karchi. Señala varias soluciones”:

- Algoritmos de detección de deepfake: “Los algoritmos de detección de deepfake pueden detectar diferencias sutiles que pueden no ser perceptibles para el ojo humano”, dice Karchi. Por ejemplo, ciertos algoritmos pueden detectar comportamientos inconsistentes en videos (p. ej., parpadeo anormal o movimientos inusuales) o verificar la plausibilidad de señales biológicas (p. ej., valores del tracto vocal o indicadores del flujo sanguíneo).

- Tecnología Blockchain: la inmutabilidad de Blockchain fortalece el poder de los algoritmos criptográficos y hash; en otras palabras, “puede proporcionar un medio para verificar la autenticidad de un activo digital y rastrear los cambios en el archivo original”, dice Karchi. Mostrar la hora de origen de un activo o verificar que no haya cambiado con el tiempo puede ayudar a exponer los deepfakes.

- Marcas de agua digitales: los sellos visibles, de metadatos o a nivel de píxeles pueden ayudar a etiquetar contenido de audio y visual creado por IA, y también se están desarrollando muchas técnicas de marcas de agua de texto digital. Sin embargo, las marcas de agua digitales no son una solución general: los piratas informáticos malintencionados aún podrían utilizar soluciones de código abierto para crear falsificaciones y existen formas de eliminar muchas marcas de agua.

Es importante señalar que las falsificaciones de IA generativa están mejorando rápidamente y los métodos de detección deben ponerse al día. “Este es un campo en continua evolución donde las tecnologías de detección y generación a menudo están atrapadas en un juego del gato y el ratón”, dice Karchi.

3. Anti-sesgo

Los sistemas sesgados pueden comprometer la equidad, la precisión, la confiabilidad y los derechos humanos, y tener serias ramificaciones legales. Los proyectos de IA generativa deben diseñarse para mitigar el sesgo desde el inicio de su diseño.

Ha encontrado dos técnicas especialmente útiles mientras trabaja en proyectos de software y ciencia de datos:

Recopilación diversa de datos: “Los datos utilizados para entrenar modelos de IA deben ser representativos de los diversos escenarios y poblaciones que estos modelos encontrarán en el mundo real”, afirma Karchi. Promover datos diversos reduce la probabilidad de resultados sesgados y mejora la precisión del modelo para diversas poblaciones por ejemplo, ciertos LLM (Son grandes modelos de lenguaje son redes neuronales capaces de leer, traducir y resumir textos) capacitados pueden responder mejor a diferentes acentos y dialectos.

4. Privacidad

Aunque existen muchas preocupaciones generativas de la IA sobre la privacidad en relación con el consentimiento de los datos y los derechos de autor, aquí nos centramos en preservar la privacidad de los datos del usuario, ya que esto se puede lograr durante el ciclo de vida del desarrollo del software. La IA generativa hace que los datos sean vulnerables de múltiples maneras: puede filtrar información confidencial del usuario utilizada como datos de entrenamiento y revelar información ingresada por el usuario a proveedores externos, lo que sucedió cuando se expusieron los secretos de la empresa Samsung.

Hotz ha trabajado con clientes que desean acceder a información confidencial o patentada desde un chatbot de documentos y ha protegido los datos ingresados por el usuario con una plantilla estándar que utiliza algunos componentes clave:

- Un LLM (Large Language Models) de código abierto alojado localmente o en una cuenta de nube privada (es decir, una VPC)

- Un mecanismo de carga de documentos o un almacén con la información privada en la misma ubicación (por ejemplo, la misma VPC)

- Una interfaz de chatbot que implementa un componente de memoria (por ejemplo, a través de Lang Chain).

Algoritmos de detección y mitigación de sesgos: los datos deben someterse a técnicas de mitigación de sesgos antes y durante el entrenamiento (por ejemplo, la eliminación de sesgos adversarios tiene un modelo que aprende parámetros que no infieren características sensibles). Más adelante, se pueden utilizar algoritmos como la equidad a través del conocimiento para evaluar el rendimiento del modelo con métricas de equidad y ajustar el modelo en consecuencia.

También señala la importancia de incorporar los comentarios de los usuarios en el ciclo de desarrollo del producto, lo que puede proporcionar información valiosa sobre los sesgos percibidos y los resultados injustos. Finalmente, contratar una fuerza laboral técnica diversa garantizará que se consideren diferentes perspectivas y ayudará a frenar el sesgo algorítmico y de IA.

“Este método permite lograr una experiencia de usuario similar a Chat GPT de forma privada”, dice Hotz. Los ingenieros podrían aplicar enfoques similares y emplear tácticas creativas de resolución de problemas para diseñar soluciones de IA generativa con la privacidad como máxima prioridad, aunque los datos de entrenamiento de la IA generativa aún plantean importantes desafíos en materia de privacidad, ya que provienen del rastreo de Internet.

5. Transparencia

Transparencia significa hacer que los resultados de la IA generativa sean lo más comprensibles y explicables posible. Sin eso los usuarios no pueden verificar ni evaluar el contenido producido por IA de manera efectiva. Si bien es posible que no podamos resolver el problema de la caja negra de la IA en el corto plazo, los desarrolladores pueden tomar algunas medidas para aumentar la transparencia en las soluciones de IA generativa.

Gupta promovió la transparencia en una variedad de funciones mientras trabajaba en 1nb.ai, una plataforma de meta análisis de datos que está ayudando a cerrar la brecha entre los científicos de datos y los líderes empresariales. Utilizando la interpretación automática de código, 1nb.ai crea documentación y proporciona información sobre datos a través de una interfaz de chat que los miembros del equipo pueden consultar.

“Para nuestra función de IA generativa que permite a los usuarios obtener respuestas a preguntas en lenguaje natural, les proporcionamos la referencia original de la que se obtuvo la respuesta (por ejemplo, un cuaderno de ciencia de datos de su repositorio)”. 1nb.ai también especifica claramente qué funciones de la plataforma utilizan IA generativa, para que los usuarios tengan agencia y sean conscientes de los riesgos.

Los desarrolladores que trabajan en chatbots pueden hacer esfuerzos similares para revelar fuentes e indicar cuándo y cómo se utiliza la IA en las aplicaciones, si pueden convencer a las partes interesadas de que acepten estos términos.

Recomendaciones para el futuro de la IA generativa en los negocios

La ética de la IA generativa no sólo es importante y urgente: probablemente también será rentable. La implementación de prácticas comerciales éticas, como las iniciativas ESG (Environmental, social, and corporate governance) está vinculada a mayores ingresos. En términos de IA específicamente, una encuesta realizada por The Economist Intelligence Unit encontró que el 75% de los ejecutivos se oponen a trabajar con proveedores de servicios de IA cuyos productos carecen de un diseño responsable.

Al ampliar nuestra discusión sobre la ética de la IA generativa a gran escala, centrándose en organizaciones enteras, surgen muchas consideraciones nuevas más allá de los cinco pilares del desarrollo ético descritos. La IA generativa afectará a la sociedad en general y las empresas deberían empezar a abordar los posibles dilemas para mantenerse a la vanguardia. Los expertos en IA de Toptal sugieren que las empresas podrían mitigar los riesgos de forma proactiva de varias formas:

- Establezca objetivos de sostenibilidad y reduzca el consumo de energía: Gupta señala que el costo de capacitar a un solo LLM como GPT-3 es enorme (es aproximadamente igual al consumo de electricidad anual de más de 1000 hogares estadounidenses) y el costo de las consultas diarias de GPT es aún mayor. Las empresas deberían invertir en iniciativas para minimizar estos impactos negativos en el medio ambiente.

- Promover la diversidad en los procesos de reclutamiento y contratación: “Las perspectivas diversas conducirán a sistemas más reflexivos”, explica Hotz. La diversidad está vinculada a una mayor innovación y rentabilidad; Al contratar para la diversidad en la industria de la IA generativa, las empresas reducen el riesgo de algoritmos sesgados o discriminatorios.

- Crear sistemas para el seguimiento de la calidad de los LLM: el rendimiento de los LLM es muy variable y las investigaciones han demostrado cambios significativos en el rendimiento y el comportamiento tanto en GPT-4 como en GPT-3.5 de marzo a junio de 2023, “Los desarrolladores carecen de un entorno estable sobre el que construir aplicaciones generativas de IA, y las empresas que dependen de estos modelos necesitarán monitorear continuamente la deriva de LLM para cumplir consistentemente con los puntos de referencia de los productos”.

- Establecer foros públicos para comunicarse con los usuarios de IA generativa: Karchi cree que mejorar (la algo faltante) conciencia pública sobre los casos de uso, los riesgos y la detección de la IA generativa es esencial. Las empresas deberían comunicar de forma transparente y accesible sus prácticas en materia de datos y ofrecer formación en IA; esto permite a los usuarios defenderse contra prácticas poco éticas y ayuda a reducir las crecientes desigualdades causadas por los avances tecnológicos.

- Implementar procesos de supervisión y sistemas de revisión: líderes digitales como Meta, Google y Microsoft han instituido juntas de revisión de IA, y la IA generativa hará que los controles y equilibrios de estos sistemas sean más importantes que nunca, dice Hotz. Desempeñan un papel esencial en varias etapas del producto, considerando las consecuencias no deseadas antes del inicio de un proyecto, agregando requisitos del proyecto para mitigar los daños y monitoreando y remediando los daños después de su lanzamiento.

A medida que se expanda la necesidad de prácticas comerciales responsables y los beneficios de tales métodos ganen visibilidad, sin duda surgirán nuevos roles, e incluso departamentos comerciales completos. En AWS, Hotz ha identificado FMOps/LLMOps* como una disciplina en evolución de importancia creciente, con una superposición significativa con la ética de la IA generativa. FMOps (operaciones del modelo básico) incluye poner en producción aplicaciones generativas de IA y monitorearlas posteriormente, explica. “Debido a que FMOps consiste en tareas como monitorear datos y modelos, tomar acciones correctivas, realizar auditorías y evaluaciones de riesgos, y establecer procesos para la mejora continua del modelo, existe un gran potencial para implementar la ética de la IA generativa en este proceso”.

* Las operaciones de modelos de lenguajes grandes (LLMOps) son un tipo específico de operaciones de aprendizaje automático (MLOps) que ofrece la infraestructura y las herramientas necesarias para facilitar la creación e implementación de LLM. LLMOps aborda la gestión del ciclo de vida de los LLM, incluyendo: Capacitación.

Independientemente de dónde y cómo se incorporen los sistemas éticos en cada empresa, está claro que el futuro de la IA generativa hará que tanto las empresas como los ingenieros inviertan en prácticas éticas y en un desarrollo responsable. La IA generativa tiene el poder de dar forma al panorama tecnológico mundial, y estándares éticos claros son vitales para garantizar que sus beneficios superan sus riesgos.